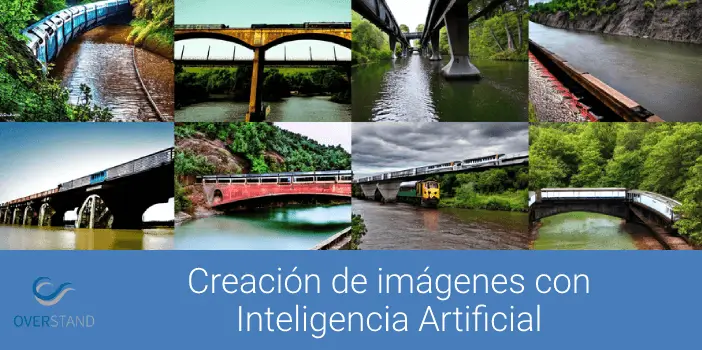

Internet tuvo un momento colectivo para sentirse bien con la presentación de DALL-E, un generador de imágenes basado en inteligencia artificial inspirado por el artista Salvador Dalí y el adorable robot WALL-E que usa lenguaje natural para producir cualquier imagen misteriosa y hermosa que su corazón desee. . Ver entradas escritas como "tuza sonriente sosteniendo un cono de helado" instantáneamente cobrar vida claramente resonó con el mundo.

Conseguir que dicha ardilla sonriente y atributos aparezcan en su pantalla no es una tarea fácil. DALL-E 2 usa algo llamado modelo de difusión, donde intenta codificar todo el texto en una descripción para generar una imagen. Pero una vez que el texto tiene muchos más detalles, es difícil que una sola descripción lo capture todo. Además, aunque son muy flexibles, a veces les cuesta entender la composición de ciertos conceptos, como confundir los atributos o las relaciones entre diferentes objetos.

Para generar imágenes más complejas con una mejor comprensión, los científicos del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT estructuraron el modelo típico desde un ángulo diferente: agregaron una serie de modelos juntos, donde todos cooperan para generar las imágenes deseadas que capturan múltiples aspectos diferentes. según lo solicite el texto de entrada o las etiquetas. Para crear una imagen con dos componentes, digamos, descritos por dos oraciones de descripción, cada modelo abordaría un componente particular de la imagen.

Los modelos aparentemente mágicos detrás de la generación de imágenes funcionan sugiriendo una serie de pasos de refinamiento iterativos para llegar a la imagen deseada. Comienza con una imagen "mala" y luego la refina gradualmente hasta que se convierte en la imagen seleccionada. Al componer varios modelos juntos, refinan conjuntamente la apariencia en cada paso, por lo que el resultado es una imagen que exhibe todos los atributos de cada modelo. Al hacer que varios modelos cooperen, puede obtener combinaciones mucho más creativas en las imágenes generadas.

Tomemos, por ejemplo, un camión rojo y una casa verde. El modelo confundirá los conceptos de camión rojo y casa verde cuando estas oraciones se vuelvan muy complicadas. Un generador típico como DALL-E 2 podría hacer un camión verde y una casa roja, por lo que intercambiará estos colores. El enfoque del equipo puede manejar este tipo de vinculación de atributos con objetos y, especialmente cuando hay varios conjuntos de cosas, puede manejar cada objeto con mayor precisión.

“El modelo puede modelar de manera efectiva las posiciones de los objetos y las descripciones relacionales, lo cual es un desafío para los modelos de generación de imágenes existentes. Por ejemplo, pon un objeto y un cubo en una determinada posición y una esfera en otra. DALL-E 2 es bueno para generar imágenes naturales, pero a veces tiene dificultades para comprender las relaciones entre objetos”, dice Shuang Li, estudiante de doctorado de MIT CSAIL y coautor principal, “más allá del arte y la creatividad, tal vez podríamos usar nuestro modelo para la enseñanza. Si quieres decirle a un niño que ponga un cubo encima de una esfera, y si lo decimos en lenguaje, puede ser difícil que lo entienda. Pero nuestro modelo puede generar la imagen y mostrarla”.

Enorgulleciendo a Dalí

Composable Diffusion, el modelo del equipo, utiliza modelos de difusión junto con operadores compositivos para combinar descripciones de texto sin más capacitación. El enfoque del equipo captura con mayor precisión los detalles del texto que el modelo de difusión original, que codifica directamente las palabras como una sola oración larga. Por ejemplo, dado "un cielo rosa" Y "una montaña azul en el horizonte" Y "flores de cerezo frente a la montaña", el modelo del equipo pudo producir esa imagen exactamente, mientras que el modelo de difusión original hizo que el cielo fuera azul y todo frente a las montañas rosadas.

“El hecho de que nuestro modelo se pueda componer significa que puedes aprender diferentes partes del modelo, una a la vez. Primero puede aprender un objeto encima de otro, luego aprender un objeto a la derecha de otro y luego aprender algo a la izquierda de otro”, dice el coautor principal y estudiante de doctorado de MIT CSAIL, Yilun Du. "Dado que podemos componerlos juntos, puede imaginar que nuestro sistema nos permite aprender de manera incremental el idioma, las relaciones o el conocimiento, lo que creemos que es una dirección bastante interesante para el trabajo futuro".

Si bien mostró destreza en la generación de imágenes fotorrealistas complejas, aún enfrentó desafíos ya que el modelo se entrenó en un conjunto de datos mucho más pequeño que aquellos como DALL-E 2, por lo que hubo algunos objetos que simplemente no pudo capturar.

Ahora que Composable Diffusion puede funcionar sobre modelos generativos, como DALL-E 2, los científicos quieren explorar el aprendizaje continuo como un próximo paso potencial. Dado que generalmente se agrega más a las relaciones de objeto, quieren ver si los modelos de difusión pueden comenzar a "aprender" sin olvidar el conocimiento aprendido previamente, hasta un lugar donde el modelo puede producir imágenes con el conocimiento previo y nuevo.

“Esta investigación propone un nuevo método para componer conceptos en la generación de texto a imagen, no concatenándolos para formar un mensaje, sino calculando puntajes con respecto a cada concepto y componiéndolos usando operadores de conjunción y negación”, dice Mark Chen, co-creador de DALL-E 2 e investigador científico en OpenAI. “Esta es una buena idea que aprovecha la interpretación basada en la energía de los modelos de difusión para que se puedan aplicar viejas ideas sobre la composicionalidad usando modelos basados ??en la energía. El enfoque también puede hacer uso de una guía sin clasificador, y es sorprendente ver que supera la línea de base GLIDE en varios puntos de referencia de composición y puede producir cualitativamente tipos muy diferentes de generaciones de imágenes”.

“Los humanos pueden componer escenas que incluyan diferentes elementos de muchas maneras, pero esta tarea es un desafío para las computadoras”, dice Bryan Russel, científico investigador de Adobe Systems. “Este trabajo propone una formulación elegante que compone explícitamente un conjunto de modelos de difusión para generar una imagen dada una indicación de lenguaje natural compleja”.

Este artículo ha sido elaborado tomando el MIT como fuente.