Cómo preparar a tu organización para el cumplimiento de la Ley de IA en 2025

La regulación europea conocida como AI Act nace con la voluntad de construir un entorno digital donde los sistemas de Inteligencia Artificial operen bajo un marco jurídico único que priorice la confianza y garantice los derechos de los ciudadanos. El propósito fundamental de esta regulación consiste en imponer requisitos proporcionales al nivel de riesgo de cada aplicación —desde la prohibición de aquellas prácticas que atentan contra la dignidad humana hasta la supervisión reforzada de los sistemas de alto riesgo—, al tiempo que garantiza condiciones homogéneas para el desarrollo y la comercialización de soluciones innovadoras en todo el mercado comunitario.

Esta nueva norma promueve la adopción de mecanismos de gestión de incidencias, la divulgación de operaciones algorítmicas y la formación adecuada de los operadores, aplicando un enfoque basado en el riesgo y la transparencia; grandes noticias para todos nosotros, pues se asume que los nuevos desarrollos pondrán su foco en la seguridad de las personas, fomentando un despliegue técnico responsable. Otro de los puntos de interés de esta regulación habla de proporcionar entornos de ensayo regulados (sandboxes) y apoyos específicos para PyMEs, con el que la norma aspira a impulsar la competitividad europea en el ámbito de la Inteligencia Artificial sin renunciar a la protección de nuestros valores democráticos.

Fases de aplicación del AI Act

Esta nueva regulación fue publicada en julio de 2024, dando paso a su entrada en vigor el 1 de agosto de ese mismo año. Este pasado 2 de febrero entraron en aplicación las prohibiciones de sistemas considerados de “riesgo inaceptable”, así como los requisitos de educación en IA con el fin de contar con un equipo con conocimientos sólidos en el dominio. Se tiene fijada la fecha del 2 de agosto de 2025 para comenzar a ser exigibles las normas de gobernanza y otras obligaciones específicas para proveedores de sistemas de Inteligencia Artificial (con propósito general). Por otro lado, será ya en 2026 cuando se prevé la plena aplicabilidad de la regulación (los sistemas considerados de “alto riesgo” que se encuentren ya integrados en productos regulados, dispondrían de un periodo adicional de transición hacia el cumplimiento del Reglamento, mancando como fecha límite el 2 de agosto de 2027).

Si buscas prepararte para el cumplimiento de esta nueva normativa, te invitamos a seguir leyendo este artículo, a fin de aclarar las posibles dudas que puedan surgirte y contar con un plan sólido que te ayude a estar preparado.

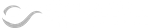

Ámbito de aplicación y actores implicados

El nuevo Reglamento proporciona detalles acerca las responsabilidades que tienen las distintas partes, para las que indican 4 categorías principales:

- Proveedor. Es aquella persona física o jurídica que desarrolla o comercializa un sistema de Inteligencia Artificial bajo su nombre o marca, y asume la responsabilidad de su conformidad.

- Distribuidor. Es aquella persona física o jurídica que pone un sistema de Inteligencia Artificial a disposición en el mercado, sin modificarlo sustancialmente. Este distribuidor debe asegurarse de que el sistema cumple con el Reglamento antes de su comercialización.

- Importador. Se trata de aquella persona física o jurídica, establecida en la UE, que introduce por primera vez un sistema de Inteligencia Artificial procedente de fuera de la UE. Este importador debe asumir las obligaciones del fabricante si hace uso del sistema para fines comerciales, o realiza modificaciones sustanciales en el mismo.

- Usuario final o deployer. Se trata de aquella persona física o jurídica, agencia u organismo público que emplea un sistema de Inteligencia Artificial bajo su propia autoridad con fines profesiones o comerciales. El usuario final debe garantizar el uso del software conforme a las instrucciones proporcionadas por el proveedor.

Una vez aclarado el perfil de cada uno de estos roles, introduzcamos que responsabilidades se vinculan a cada uno:

- Proveedores.

- Tienen el deber de garantizar que sus sistemas cumplen los requisitos de gestión de riesgos, documentación técnica y transparencia antes de su comercialización.

- Es imprescindible que los proveedores establezcan mecanismos de seguimiento post-comercialización. A su vez, todo reporte de incidencias graves debe ser notificado a las autoridades competentes.

- Distribuidores.

- Deben verificar que los sistemas de Inteligencia Artificial con los que operan llevan la documentación y el marcado CE (aplicable en sistemas de alto riesgo) correspondientes.

- En caso de tener conocimiento o motivos de sospecha para creer que un sistema no cumple con el Reglamento, los distribuidores deberán retirarlo del mercado e informar inmediatamente a las autoridades.

- Importadores.

- Deben asegurarse de que el proveedor fuera de la UE cumple con los requisitos que especifica el Reglamento, así como conservar la documentación necesaria.

- Los importadores deberán cooperar con las autoridades de vigilancia del mercado. En caso de incumplimiento del proveedor, los importadores actuarán como “fabricante”, asumiendo las obligaciones pertinentes.

- Usuarios finales.

- Tienen la obligación de implementar los sistemas de Inteligencia Artificial según las instrucciones que especifica el proveedor. En caso necesario, los usuarios finales serán los que garanticen la supervisión humana adecuada de los sistemas.

- Los usuarios finales deben reportar cualquier indicente o mal funcionamiento, así como mantener registros de uso de los sistemas cuando proceda.

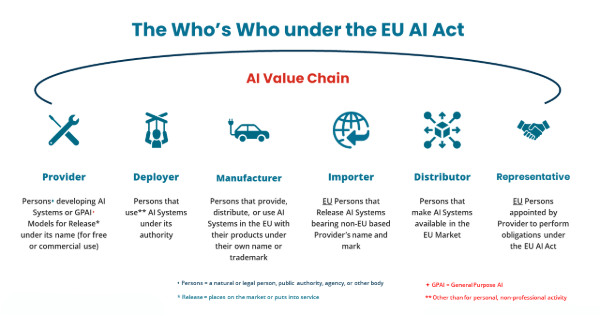

Clasificación de sistemas IA y niveles de riesgo

El nuevo Reglamento clasifica a los sistemas de IA en cuatro niveles de riesgo (la finalidad de esta clasificación no es otra que ajustar los niveles de conformidad a la potencial afectación a los derechos y seguridad de las personas).

En la cúspide de la pirámide, encontramos aquellas prácticas consideradas inaceptables, cuyo uso está vetado de manera absoluta desde el 2 de febrero (2025). Por debajo de este nivel, encontramos los sistemas de “alto riesgo”, los cuales deben ser sometidos a controles periódicos y evaluaciones estrictas antes de su comercialización. Los niveles inferiores, propios para sistemas de “riesgo limitado” y sistemas de “riesgo insignificante”, solamente precisan medidas de transparencia, quedando estos últimos exentos de obligaciones adicionales (se entiende que conllevan un impacto mínimo en los derechos y seguridad del usuario final).

A continuación, exponemos cada uno de estos niveles, y definimos el concepto de riesgo al que el Reglamento hace alusión:

- Riesgo inaceptable. Corresponde a prácticas prohibidas por vulnerar derechos fundamentales o generar daños graves a sus usuarios (no de manera directa). Entre los usos vetados por el Reglamento figuran la manipulación del comportamiento humano a través de técnicas subliminales, el social scoring por parte de autoridades o empresas, y la vigilancia biométrica masiva sin garantías procesales. La prohibición es inmediata y extensiva a toda la Unión Europea (2 de febrero de 2025).

- Alto riesgo. Engloba sistemas que pueden afectar la seguridad o derechos de las personas si no se gestionan adecuadamente. Dentro de este nivel podemos encontrar dos grupos principales:

- Sistemas integrados en productos regulados por la legislación de seguridad (juguetes, vehículos, ascensores; entre otros).

- Sistemas destinados a ámbitos críticos (selección de personal, evaluación de crédito, gestión de procesos judiciales; entre otros).

- Riesgo limitado. Incluye aplicaciones con un potencial bajo de afectar a los derechos humanos, pero que requieren transparencia adicional. Un ejemplo serían los chatbots o sistemas de recomendación, cuyo funcionamiento debe notificarse a los usuarios antes de su uso.

- Riesgo insignificante. Este nivel engloba a la mayoría de sistemas de IA, como pueden ser los filtros de spam, que no exigen obligaciones adicionales más allá de las prácticas generales de desarrollo responsable.

¿Cómo se determina el nivel de riesgo de un sistema de Inteligencia Artificial?

La Unión Europea declara que la evaluación se basa en el propósito declarado del sistema, el contexto de uso, y la gravedad del posible daño que este pudiese ocasionar. Serán los proveedores los encargados de documentar el análisis de riesgos y entregarlo en conjunto con el sistema durante su comercialización.

Medidas de apoyo específicas para PyMEs

En el Reglamento en vigor del AI Act se da especial atención a las PyMEs. La Unión Europea otorga a este conjunto de empresas ciertas medidas que les faciliten la validación de soluciones antes de su despliegue comercial, garantizando que todos los proveedores estén, en la medida de lo posible, en igualdad de condiciones para llevar a cabo todos los análisis de riesgo pertinentes. Paralelamente a estas medidas, debido al impulso del paquete de innovación en Inteligencia Artificial, las líneas de financiación del programa de Next Generation EU ofrecen subvenciones, consultoría y formacion para facilitar que la adopción de sistemas de IA se lleve a cabo de forma asequible y segura.

Entre las medidas de apoyo para PyMEs que se citan en el Reglamento del AI Act, encontramos:

- Reducción de costes. Los requisitos de conformidad para sistemas de alto riesgo contemplan tarifas reducidas para pequeñas y medianas empresas en las evaluaciones que se requieran a nivel externo, con el fin de minimizar barreras económicas y fomentar la innovación local.

- Herramientas de autodiagnóstico. La comunidad de EU AI Act Explorer pone a disposición un “AI Act Compliance Checker”. Se trata de un formulario de ayuda a las PyMEs para una evaluación guiada de sus posibles obligaciones y la preparación de la documentación necesaria para sus sistemas.

- Entornos regulatorios de ensayo (sandboxes). Estos entornos ofrecen marcos controlados para probar sistemas de IA con supervisión regulatoria, ayudando de forma proactiva a distribuidores para llevar a cabo ajustes tempranos y facilitando el proceso de demostración de cumplimiento ante las autoridades.

Hitos y responsabilidades para el cumplimiento del AI Act

La reciente imposición del nuevo Reglamento, junto con las medidas que están por llegar, suponen un cambio de paradigma en el desarrollo de sistemas de Inteligencia Artificial, enfocada en la transparencia y en salvaguardar los derechos de todas las personas. Independientemente del rol que ejerzas con respecto al uso de la Inteligencia Artificial, conviene tener en presente las responsabilidades que puedas tener. No obstante, el mayor cambio sugiere que proveedores y distribuidores de los sistemas de IA adapten su flujo de trabajo en consecuencia a las nuevas medidas. A continuación, ofrecemos un resumen de hitos y responsabilidades que aplican, principalmente, a los roles citados anteriormente.

Revisión inicial del marco legal

Antes de cualquier actuación, la empresa debe acceder al Reglamento (EU) 2024/1689 y familiarizarse con las disposiciones publicadas en el Diario Oficial de la UE el 12 de julio de 2024. Este primer paso permite comprender el alcance de las obligaciones y detectar los artículos más relevantes para los sistemas de IA que se utilizan o desarrollan en la organización.

Clasificación de sistemas y evaluación de riesgo

Para cada producto o servicio basado en IA, es esencial determinar el nivel de riesgo según las categorías definidas en el AI Act. Este análisis exige un examen sistemático del propósito y el contexto de uso, así como la asignación de un responsable que documente los hallazgos y actualice el registro de riesgos siempre que se incorporen nuevas funcionalidades.

Desarrollo de gobernanza interna

Es recomendable designar la figura de “Responsable de IA” o formar un comité de cumplimiento que supervise todas las fases del ciclo de vida de los sistemas. Ese órgano deberá poner en marcha mecanismos de vigilancia tras la comercialización, así como protocolos claros para notificar y gestionar cualquier incidente grave ante las autoridades competentes.

Fomentar la formación y educación en IA

Diseñar un plan de capacitación adaptado a los diferentes roles implicados. Un enfoque útil podría basarse en la programación de sesiones periódicas para garantizar que todos los empleados comprenden sus obligaciones legales. Es importante que se asimilen los contenidos mediante evaluaciones internas o actividades prácticas vinculadas a casos de uso reales.

Preparación de evaluaciones de conformidad

La organización debe decidir si realizará una autoevaluación o recurrirá a un organismo notificado. Tras esto, conviene elaborar un calendario de auditorías internas (en el caso de las PyMEs, pueden aprovechar las tarifas reducidas disponibles para minimizar los costes sin renunciar a la rigurosidad en el proceso).

Acceso a entornos controlados (sandboxes)

Con el fin de probar soluciones de IA que se encuentren bajo supervisión regulatoria, pueden ser de utilidad las convocatorias de sandboxes nacionales y comunitarios que se organicen eventualmente. Participar en estos entornos facilita la detección temprana de incumplimientos legales y la obtención de certificaciones, previas al lanzamiento comercial de los sistemas.

Cooperación con autoridades nacionales y europeas

Registrar la entidad ante la autoridad competente del Estado miembro correspondiente constituye un requisito previo indispensable. Mantener canales abiertos con los organismos de supervisión permite recibir de forma ágil las últimas guías y actualizaciones.

Evaluación continua y actualización

Es imprescindible programar revisiones periódicas del cumplimiento normativo, y ajustar los procesos internos a medida que entren en vigor nuevas obligaciones, como los requisitos para sistemas de propósito general previstos a partir de agosto de 2025.

Este es un artículo de opinión, no válido para tomar acciones ni decisiones legales. Te recomendamos consultar con tu asesor jurídico para el cumplimiento de la Ley de IA que se aplicará el 2 de agosto de 2025 en la Unión Europea.