La aplicación del Reglamento Europeo de IA ha hecho de la transparencia un requisito fundamental en los sistemas de Inteligencia Artificial modernos. Este nuevo marco normativo obliga a que los modelos sean capaces de explicar sus propias decisiones; necesidad que resulta crítica en ciertos sectores de alto impacto, como la sanidad, las finanzas o la justicia. Acorde a esta nueva realidad, se están consolidando en España y Europa los regulatory sandboxes, entornos de pruebas que permiten a las organizaciones experimentar con la innovación de forma controlada y segura.

Sin embargo, el propio avance tecnológico plantea desafíos constantes, donde la irrupción de la computación cuántica y el desarrollo de agentes de IA cada vez más autónomos obligan a replantear continuamente las estrategias de explicabilidad. En este artículo exploramos las herramientas y metodologías que se emplean para crear modelos interpretables, apoyándonos en casos de uso concretos. También abordaremos los retos éticos que conlleva este cambio, y las estrategias necesarias para construir un ecosistema de IA fiable y transparente.

Contexto regulatorio y políticas de transparencia

El marco regulatorio de la Inteligencia Artificial en Europa está implantándose mediante varias etapas, con la entrada en vigor del Reglamento de IA (Reglamento (UE) 2024/1689). Esta normativa impone un calendario de obligaciones escalonado que finalizó el pasado mes de agosto, exigiendo que todos los sistemas clasificados como de "alto riesgo" cumplan con estrictos requisitos de trazabilidad, explicabilidad y mitigación de sesgos. El objetivo no es otro que garantizar que las decisiones automatizadas sean seguras y plenamente auditables en las áreas más críticas.

En este contexto, y mediante el Real Decreto 817/2023, España se ha posicionado como uno de los primeros sandboxes regulatorios de la Unión Europea. Estos espacios controlados buscan conciliar la innovación con la protección de los derechos fundamentales. La supervisión de este ecosistema recae en la recién creada Agencia Española de Supervisión de la Inteligencia Artificial (AESIA), un organismo con potestad para velar por el cumplimiento normativo y sancionar las malas prácticas, sentando así las bases para un entorno de IA transparente y fiable.

Tendencias tecnológicas actuales. La computación cuántica y los agentes de IA transparentes

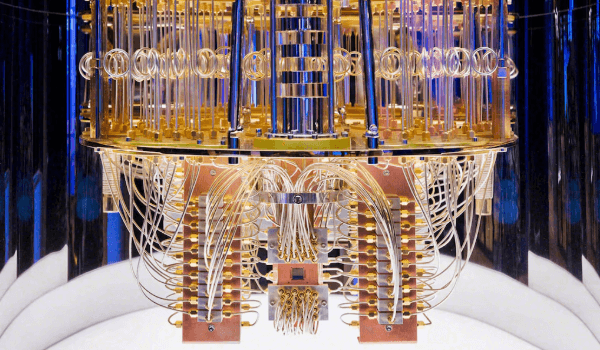

El sector tecnológico ha experimentado cambios durante todo el año, aunque dos de los avances más destacados y sorprendentes bien podrían ser el nacimiento de la computación cuántica, y el auge de los agentes de IA con capacidades cada vez más cerca de un agente autónomo. Europa impulsa con fuerza la primera de ellas, con una inversión de 800 millones de euros a través de su Estrategia de Tecnologías Cuánticas. Si bien los ordenadores cuánticos prometen acelerar el entrenamiento de modelos, su propia naturaleza nos genera ciertas dudas sobre la necesidad de justificar las decisiones de los algoritmos.

Los agentes de Inteligencia Artificial autónomos se encuentran en la misma línea. Aquí, el reto para la transparencia reside en comprender la lógica que emerge de sus interacciones. Ambas tendencias fuerzan a los desarrolladores a ir más allá de las técnicas actuales, y fundamentar la arquitectura de estos sistemas avanzados en la transparencia y la explicabilidad.

Herramientas y metodologías para desarrollar modelos interpretables

Para desentrañar el funcionamiento de los modelos de IA, los desarrolladores disponen de un abanico de metodologías que abarcan desde la interpretación a posteriori hasta el uso de arquitecturas transparentes por diseño. Una práctica extendida es el análisis de modelos complejos con herramientas que asignan un peso específico a cada variable en la decisión final, de forma que entendamos cómo afectan los diferentes atributos a la respuesta del modelo (como ocurre con SHAP o LIME). Si bien la información que nos proporcionan estas herramientas es muy reveladora, en casos donde se trabaje con modelos de gran complejidad, es posible que no sea suficiente para comprender el porqué de una decisión. Dada esta situación, se entiende que en sectores como la banca, las entidades financieras en España opten por modelos intrínsecamente interpretables, como es el caso de los árboles de decisión.

La necesidad de este cambio ha motivado la evolución de la industria hacia plataformas como Microsoft Azure Machine Learning, que automatizan la generación de informes de explicabilidad. Uno de los componentes fundamentales de estas plataformas es el diagnóstico de sesgos, con el fin de verificar que los modelos no discriminen por motivos de género, edad u origen. Se puede razonar que la tendencia actual no se limita a explicar el resultado; es necesario documentar de manera integral la equidad de los algoritmos.

Proyectos y casos de éxito en España y Europa

En España, el proyecto Alia es el principal referente en materia de transparencia, un modelo entrenado en español y lenguas cooficiales que opera bajo código abierto y la supervisión de la AESIA, garantizando que sus componentes sean plenamente auditables. Su aplicación ya se explora en proyectos piloto como Cardiomentor, destinada a ofrecer diagnósticos en el ámbito médico, acompañados ahora de una explicación clara sobre los factores que motivan cada recomendación.

La iniciativa del proyecto Alia se enmarca en una tendencia continental representada por el consorcio OpenEuroLLM. Financiado al completo por la Unión Europea, este proyecto integra herramientas de explicabilidad desde su concepción, conformando el desarrollo de una IA pública cuyo valor reside en, además de su potencia, la capacidad de sus modelos para rendir cuentas.

Desafíos éticos y recomendaciones estratégicas

El principal desafío ético de la Inteligencia Artificial reside en el sesgo que sufren los algoritmos. En los últimos años, se han dado casos en todo el mundo de modelos que acaban perpetuando discriminaciones de género, origen étnico o edad, motivados por unos datos históricos incompletos empleados durante el entrenamiento. Para atajar este problema, se han establecido diversos grupos de trabajo europeos con el objetivo de presentar un Código de Buenas Prácticas para la gestión de riesgos en sistemas de Inteligencia Artificial a gran escala.

La estrategia más eficaz para afrontar este reto es la creación de equipos multidisciplinares capaces de integrar la privacidad y la equidad desde las fases de diseño de cada proyecto. Fomentar estos protocolos, junto a la adopción de estándares de código abierto y auditorías periódicas, es fundamental para consolidar un ecosistema tecnológico donde nuestra confianza como personas sea el resultado de un proceso transparente y responsable.