Si su conductor Uber toma un atajo, puede llegar a su destino más rápido. Pero si un modelo de aprendizaje automático toma un atajo, podría fallar de formas inesperadas.

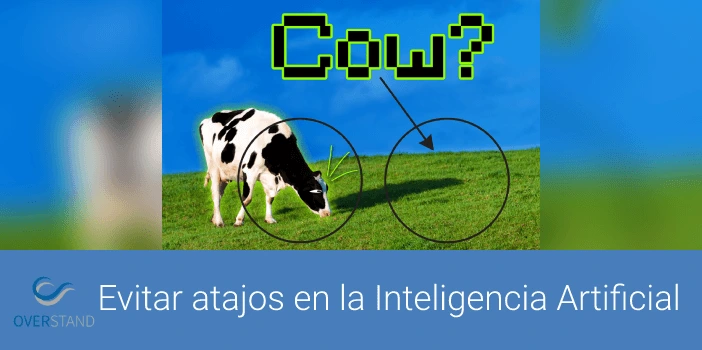

En el aprendizaje automático, se produce una solución rápida cuando el modelo se basa en una característica simple de un conjunto de datos para tomar una decisión, en lugar de aprender la verdadera esencia de los datos, lo que puede conducir a predicciones inexactas. Por ejemplo, un modelo podría aprender a identificar imágenes de vacas enfocándose en la hierba verde que aparece en las fotos, en lugar de las formas y patrones más complejos de las vacas.

Un nuevo estudio realizado por investigadores del MIT explora el problema de los atajos en un popular método de aprendizaje automático y propone una solución que puede evitar los atajos al obligar al modelo a usar más datos en su toma de decisiones.

Al eliminar las características más simples en las que se centra el modelo, los investigadores lo obligan a centrarse en características más complejas de los datos que no había considerado. Luego, al pedirle al modelo que resuelva la misma tarea de dos maneras, una vez usando esas funciones más simples y luego también usando las funciones complejas que ahora ha aprendido a identificar, reducen la tendencia a las soluciones rápidas y aumentan el rendimiento del modelo.

Una posible aplicación de este trabajo es mejorar la eficacia de los modelos de aprendizaje automático que se utilizan para identificar enfermedades en imágenes médicas. Las soluciones rápidas en este contexto podrían conducir a diagnósticos falsos y tener implicaciones peligrosas para los pacientes.

“Todavía es difícil decir por qué las redes profundas toman las decisiones que toman y, en particular, en qué partes de los datos eligen enfocarse estas redes al tomar una decisión. Si podemos entender cómo funcionan los atajos con más detalle, podemos ir aún más lejos para responder algunas de las preguntas fundamentales pero muy prácticas que son realmente importantes para las personas que intentan implementar estas redes”, dice Joshua Robinson, estudiante de doctorado en la Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) y autor principal del artículo.

Robinson escribió el artículo con sus asesores, el autor principal Suvrit Sra, profesor asociado de desarrollo profesional de Esther y Harold E. Edgerton en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación (EECS) y miembro principal del Instituto de Datos, Sistemas y Sociedad (IDSS) y el Laboratorio de Sistemas de Información y Decisión; y Stefanie Jegelka, profesora asociada de desarrollo profesional de X-Consortium en EECS y miembro de CSAIL e IDSS; así como el profesor asistente de la Universidad de Pittsburgh Kayhan Batmanghelich y los estudiantes de doctorado Li Sun y Ke Yu. La investigación se presentará en la Conferencia sobre Sistemas de Procesamiento de Información Neural en diciembre.

El largo camino para entender los atajos

Los investigadores centraron su estudio en el aprendizaje contrastivo, que es una forma poderosa de aprendizaje automático autosupervisado. En el aprendizaje automático autosupervisado, un modelo se entrena utilizando datos sin procesar que no tienen descripciones de etiquetas de humanos. Por lo tanto, se puede utilizar con éxito para una mayor variedad de datos.

Un modelo de aprendizaje autosupervisado aprende representaciones útiles de datos, que se utilizan como entradas para diferentes tareas, como la clasificación de imágenes. Pero si el modelo toma atajos y no logra capturar información importante, estas tareas tampoco podrán usar esa información.

Por ejemplo, si se entrena un modelo de aprendizaje autosupervisado para clasificar la neumonía en las radiografías de varios hospitales, pero aprende a hacer predicciones basadas en una etiqueta que identifica el hospital del que proviene la exploración (porque algunos hospitales tienen más casos de neumonía). casos que otros), el modelo no funcionará bien cuando reciba datos de un nuevo hospital.

Para los modelos de aprendizaje contrastivos, se entrena un algoritmo codificador para discriminar entre pares de entradas similares y pares de entradas diferentes. Este proceso codifica datos ricos y complejos, como imágenes, de una manera que el modelo de aprendizaje contrastivo puede interpretar.

The researchers tested contrastive learning encoders with a series of images and found that, during this training procedure, they also fall prey to shortcut solutions. The encoders tend to focus on the simplest features of an image to decide which pairs of inputs are similar and which are dissimilar. Ideally, the encoder should focus on all the useful characteristics of the data when making a decision, Jegelka says.

So, the team made it harder to tell the difference between the similar and dissimilar pairs, and found that this changes which features the encoder will look at to make a decision.

“If you make the task of discriminating between similar and dissimilar items harder and harder, then your system is forced to learn more meaningful information in the data, because without learning that it cannot solve the task,” she says.

But increasing this difficulty resulted in a tradeoff — the encoder got better at focusing on some features of the data but became worse at focusing on others. It almost seemed to forget the simpler features, Robinson says.

To avoid this tradeoff, the researchers asked the encoder to discriminate between the pairs the same way it had originally, using the simpler features, and also after the researchers removed the information it had already learned. Solving the task both ways simultaneously caused the encoder to improve across all features.

Their method, called implicit feature modification, adaptively modifies samples to remove the simpler features the encoder is using to discriminate between the pairs. The technique does not rely on human input, which is important because real-world data sets can have hundreds of different features that could combine in complex ways, Sra explains.

From cars to COPD

The researchers ran one test of this method using images of vehicles. They used implicit feature modification to adjust the color, orientation, and vehicle type to make it harder for the encoder to discriminate between similar and dissimilar pairs of images. The encoder improved its accuracy across all three features — texture, shape, and color — simultaneously.

To see if the method would stand up to more complex data, the researchers also tested it with samples from a medical image database of chronic obstructive pulmonary disease (COPD). Again, the method led to simultaneous improvements across all features they evaluated.

While this work takes some important steps forward in understanding the causes of shortcut solutions and working to solve them, the researchers say that continuing to refine these methods and applying them to other types of self-supervised learning will be key to future advancements.

“This ties into some of the biggest questions about deep learning systems, like ‘Why do they fail?’ and ‘Can we know in advance the situations where your model will fail?’ There is still a lot farther to go if you want to understand shortcut learning in its full generality,” Robinson says.

Esta investigación cuenta con el apoyo de la Fundación Nacional de Ciencias, los Institutos Nacionales de Salud y el programa SAP SE Commonwealth Universal Research Enhancement (CURE) del Departamento de Salud de Pensilvania.

Este artículo ha sido elaborado tomando el MIT como fuente.