En un contexto donde la soledad y los trastornos emocionales afectan a un porcentaje creciente de la población europea, la Inteligencia Artificial emocional surge como un recurso innovador para ofrecer apoyo psicológico a quienes lo necesiten. Actualmente existen chatbots y asistentes virtuales capaces de reconocer estados de ánimo, y mantener conversaciones por voz con las personas; herramientas que están irrumpiendo en clínicas y hogares de España y de otros países de la Unión Europea.

Dedicamos este artículo a examinar el auge de estas soluciones, sus beneficios y riesgos, los retos éticos y regulatorios que plantean y, finalmente, las claves para integrarlas de forma responsable en nuestro sistema de salud mental.

La epidemia de soledad y el surgimiento de soluciones basadas en Inteligencia Articial

En Europa, la soledad afecta a más de 30 millones de adultos que la experimentan con frecuencia, y se estima que otros 75 millones tienen contacto con amigos o familiares apenas una vez al mes, según la Comisión Europea. España también sufre este problema, donde uno de cada cinco habitantes se siente aislado, lo que genera un impacto económico cercano a 14.000 millones de euros al año entre pérdida de productividad y costes sanitarios.

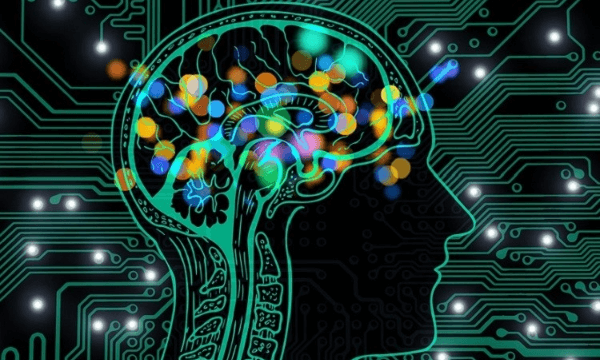

Frente a esta realidad, la Inteligencia Artificial ha dado un paso adelante ofreciendo compañía y escucha a través de chatbots terapéuticos. Se espera que su mercado crezca un 9.3 % durante este año, alcanzando 1.380 millones de dólares americanos; reflejo de su rápida implantación. Woebot y Wysa son ejemplos de chatbots que sostienen conversaciones guiadas por técnicas de terapia cognitivo-conductual, ayudando a sus usuarios a reconocer y gestionar la ansiedad en tiempo real. Un estudio publicado en Nature comprobó que quienes interactuaron con estos asistentes mostraron una mejoría en su estado de ánimo y reservaron con mayor facilidad una primera cita con un profesional.

En ámbitos universitarios, han tenido lugar experimentos con chatbots sociales que han logrado disminuir en más de un 30 % la sensación de soledad y la ansiedad en los participantes tras un mes de uso continuo. Estas herramientas no pretenden en ningún momento sustituir el trato humano (en cierto modo, no representan algo tangible, y mantener conversaciones con ellas tampoco resulta igual de satisfactorio que hacerlo con una persona real). Sin embargo, sí que ayudan a reforzar el trato humano y a escuchar los problemas de las personas, ofreciendo un primer recurso accesible para quienes carecen de redes de apoyo cercanas y detectando a tiempo la necesidad de intervención clínica.

Aplicaciones actuales de la IA emocional en el apoyo psicológico

Hemos introducido a un par reconocido de los asistentes terapéuticos más reconocidos, Woebot y Wysa, que ya se han hecho un hueco entre quienes buscan una primera línea de escucha. Woebot, desarrollado junto a psicólogos de Stanford, propone diálogos guiados por terapia cognitivo-conductual para aliviar la ansiedad y el estrés. Los usuarios de este asistente han experimentado mejoras notables en síntomas de depresión tras apenas dos semanas de uso continuo. Por su parte, Wysa acompaña con ejercicios de mindfulness y mensajes positivos, ajustando sus sugerencias al estado de ánimo detectado mediante el análisis del lenguaje de cada persona. Esta personalización ha incrementado en más del 40 % la adherencia a los programas de bienestar de la empresa.

En España, vemos cómo la tendencia de usar asistentes virtuales ha encontrado su lugar dentro del ámbito sanitario, y es que el Servicio Navarro de Salud ha añadido a su oferta digital un módulo llamado “E-Coach”. Cada día, este asistente virtual revisa las respuestas de pacientes con trastornos del ánimo leves, evalúa riesgos de recaída y alerta al equipo clínico si detecta patrones preocupantes, acortando hasta en un 25 % el tiempo de intervención.

Estos son algunos ejemplos que confirman que la Inteligencia Artificial emocional no sustituye al profesional de la salud mental; más bien ofrece un aliado disponible a cualquier hora, y sirve de ayuda para motivar a la persona a acudir a profesionales cualificados. Así, las plataformas digitales amplían el alcance de la atención, detectan cambios de estado emocional en tiempo real y conectan al paciente con ayuda profesional justo cuando más lo necesita.

Beneficios observados y riesgos asociados al uso de IA en salud mental

Varios estudios evidencian que los asistentes emocionales basados en Inteligencia Artificial facilitan el acceso a apoyo psicológico, especialmente en aquellas zonas con menos especialistas. En programas de intervención dirigidos a profesionales sanitarios, se ha documentado un 30 % de mejora en el bienestar emocional tras incorporar chatbots como complemento a las terapias convencionales.

No obstante, un uso prolongado de estos sistemas plantea sus propios retos. Se han llevado a cabo algunas investigaciones conjuntas de OpenAI y el MIT que muestran que los usuarios que hacen un uso intensivo de estas herramientas pueden experimentar un aumento de la dependencia emocional y una caída en las interacciones sociales presenciales tras varias semanas de uso continuo. Los estudios realizados en entornos europeos advierten además sobre el riesgo de establecer relaciones unilaterales con entidades carentes de empatía genuina, lo que podría agravar la sensación de aislamiento si el chatbot se convierte en única fuente de consuelo.

Para garantizar un equilibrio saludable, resulta imprescindible definir protocolos de uso que limiten la exposición continuada, incorporen alertas de seguimiento y conjunten la tecnología con el acompañamiento de profesionales de la salud mental.

Consideraciones éticos y desafíos regulatorios

La información emocional que capturan estos asistentes (que puede ir desde matices en la voz hasta expresiones faciales) requiere un tratamiento cuidadoso. El RGPD clasifica estos datos como “especiales” y exige un consentimiento claro y diferenciado, además de evaluaciones de impacto cuando el perfilado pueda atentar contra derechos fundamentales. Los desarrolladores deben aplicar desde la fase de diseño unos principios básicos de privacidad: recopilar solo lo estrictamente necesario, cifrar las comunicaciones de extremo a extremo y explicar con transparencia qué datos se usan y con qué finalidad.

El AI Act sitúa a las herramientas de apoyo emocional en la categoría de “alto riesgo”, lo que implica registrar los orígenes y la calidad de los datos de entrenamiento, someterse a auditorías independientes y ofrecer vías de recurso humano frente a decisiones automatizadas. En España, el actual borrador de la Ley de Cohesión Digital añade un bloque dedicado a la salud mental, planteando la obligación de auditar algoritmos y formar a los profesionales que los empleen. Estas normativas buscan equilibrar la innovación con la seguridad y la ética, garantizando que la IA emocional se desarrolle y crezca bajo supervisión y respeto a la privacidad de los usuarios.

Perspectivas a futuro y recomendaciones para una integración responsable

El camino hacia una Inteligencia Artificial emocional madura y segura en salud mental pasa por estrechar la colaboración entre desarrolladores, clínicos y responsables políticos. La designación de la Universitat Oberta de Catalunya como Centro Colaborador de la OMS en salud digital marca un punto de inflexión: su mandato incluye elaborar guías y metodologías para integrar soluciones de telemedicina y apoyo emocional basadas en IA en los sistemas de salud nacionales.

Para maximizar beneficios y mitigar riesgos, conviene adoptar un enfoque de “IA de confianza” guiado por principios como los del marco FUTURE-AI, que ya contarán con respaldo del AI Act durante los próximos años. Desde OverStand, recomendamos:

- Entornos pilotos regulados, donde se puedan validar chatbots y dispositivos de asistencia emocional bajo la supervisión de organismos sanitarios, centros académicos y comités de bioética.

- Establecer mecanismos de evaluación continua, que incluyan auditorías técnicas de sesgos algorítmicos y sistemas de alerta para detectar posibles situaciones de dependencia o uso intensivo no saludable.

- Fomentar la formación transversal, dotando a profesionales de salud mental de competencias en análisis de datos e IA, y a ingenieros de conocimientos básicos en psicología clínica y comunicación empática.

- Crear espacios de diálogo permanentes entre pacientes, expertos y legisladores, facilitados por programas como EU4Health, que permitan financiar iniciativas centradas en el acceso equitativo y la innovación responsable.

De seguirse este marco de medidas, se crearía un marco sólido donde los avances de la IA emocional se integren con ética, seguridad y eficacia, asegurando que sus aportaciones en salud mental alcancen a toda la población con garantías.